先月号では、最近話題となっているテキスト生成AI「ChatGPT」についてご紹介しましたが、今回はテキスト以外の利用方法として画像生成についてご紹介します。

OpenAI社が提供する画像生成AI「DALL-E2」

DALL-Eは、前号で紹介した「ChatGPT」を提供するOpenAI社によって開発された画像生成AIで、テキストから現実的な画像を生成することができます。DALL-Eは、ディープラーニングを用いた生成モデルであり、GPT-3と同様の技術を使用しています。

DALL-Eは、一般的な物体や概念、架空のものなど、さまざまな種類の画像を生成することができます。例えば、「空を飛ぶ犬の絵を描いてください」というような指示に従い、空を飛んでいる犬の画像を生成することができます。

DALL-Eは、より複雑な指示にも応えることができます。例えば、「1000年後の月に生息する白いうさぎを描いてください」という指示に従い、1000年後に生息する白いウサギを配置し、その画像を生成することができます。

DALL-Eの開発には、大量のデータが使用されましたが、その他にGoogleから提供されたデータセットに加え、自社で新たに収集したデータを使用しています。このデータセットには、アニメや漫画など、様々な種類の画像が含まれています。

DALL-Eの動作原理は、テキストと画像の相互変換を可能にするTransformerと呼ばれる技術に基づいています。Transformer技術は、自然言語処理において高い精度を発揮することが知られている、ニューラルネットワークの一種です。従来のリカレントニューラルネットワーク(RNN)に代わる、自然言語処理の最先端技術の一つとして開発されました。

Transformerは、元々、機械翻訳のタスクに使用されることを目的として開発されましたが、DALL-Eでは、Transformerを画像生成タスクに適用することによって、テキストから画像を生成することができるようになっています。これは、従来のRNNとは異なり、時系列データに依存する再帰的な処理を行うのではなく、自己注意機構と言われるデータの流れ方自体を学習し決定するような方法を利用して、任意の位置の単語を同時に処理することができます。この自己注意機構により、より長い文書を処理することができるようになり、処理速度も高速化されます。

このTransformerは、エンコーダー(変換入力)とデコーダー(変換出力)の2つの主要な要素から構成されます。エンコーダーは、入力テキストを単語レベルでエンコードし、それをデコーダーに渡すことで、デコーダーはそれを画像に変換します。

Transformerは、各単語の位置情報を加えることで、シーケンス内の単語の順序を考慮します。また、複数のエンコーダーとデコーダーを使用することによって、複数の画像の生成を同時に行うこともできます。

DALL-Eのこの技術は、高品質な画像生成を可能にするために重要な役割を果たしています。Transformerによる自己注意機構は、画像生成に必要な情報をより正確に取り出すことができ、より高品質な画像を生成することができます。

DALL-E2の応用範囲は広く、例えば、医療分野では、症状をテキストで説明することで、患者の状態に合わせた画像を生成することができます。また、商品画像の自動生成や、建築家が想像する建物の外観をテキストで説明し、それに基づいて画像を生成することも可能です。https://labs.openai.com/

画像生成AI「Midjourney」

ミッドジャーニー(Midjourney)とはジェスチャー入力技術を開発した米リープ・モーション(Leap Motion)の創業者、デビッド・ホルツ氏が共同創業した企業が手掛ける画像AIです。

MidjourneyもDall-E同様自己学習型であり、人工知能が自らの過去の学習結果から新たな知識を獲得し、改善を行うことができます。MidJourneyの最も特徴的な機能の一つは、AIによるアート作品の生成です。MidJourneyのAIは、自然言語処理技術を用いて、テキストの記述から美術作品を生成することができます。DALL-EとMidjoureyの違いは生成対象として、MidJourneyは、テキストから美術作品を生成することに特化しています。一方、DALL-Eは、テキストから現実的な画像を生成することに特化しています。つまり、MidJourneyは芸術的表現を中心に、DALL-Eは現実的な画像の生成に特化しているという点が異なります。使用技術の違いとしては、MidJourneyは、自己学習型AIを用いており、自然言語処理技術やディープラーニングによる画像生成技術を組み合わせて、美術作品の生成を行います。一方、DALL-Eは、前述した通りGPT-3という自然言語処理技術に基づく画像生成AIであり、画像生成にはTransformerと呼ばれるニューラルネットワークアーキテクチャが使用されています。

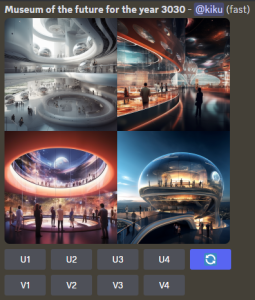

プロンプト:3030年の未来美術館を描き出した絵

テキストから画像へのプロンプトだけでない拡張性「Stable Diffusion XL」

Stable Diffusion(ステーブルディフュージョン)はドイツのミュンヘン大学の研究チームが開発した画像生成AIです。Stability AI(スタビリティーAI)が22年8月にオープンソース形式で公開した画像生成AIであり全世界にソースコードが無償公開されたことで多くの登録ユーザーを抱えています。https://ja.stability.ai/stable-diffusion

Stable Diffusionは、画像を修正するためのいくつかの方法があります。1.インペインティング – 画像の内側を編集する、2.アウトペインティング – 元画像の外側に画像を拡張する、3.Image-to-image – ソースとなる画像を使用して新しい画像をプロンプトします。

最近ではStability AIは言語モデル「StableLM Suite」の第一弾をリリース開始し、アルファ版は30億パラメータと70億パラメータのモデルが用意されており、今後150億パラメータから650億パラメータのモデルも用意される予定です。また、アーティストとも積極的にコラボレーションをしておりプログレッシブロックの大御所、音楽界のレジェンドであるピーター・ガブリエルと共同で、Stability AI DiffuseTogether Challengeのデビューを発表しました。この画期的な取り組みは、生成AIのイメージパワーとロックンロールの殿堂入りの才能を組み合わせたもので、AI のアニメーションチャレンジシリーズの第一弾として発表しました。今後もさまざまなジャンルの人気ミュージシャンを起用する予定とあります。https://ja.stability.ai/

今回は画像生成AIについてご紹介しましたが、今後これに限らずビジネスやアート音楽の世界などにおいてもAIが多く活用される時代となりました。これに対して、積極的に活用するか否定的にとるかにより、企業の存続や発展が試される時代になるでしょう。

フィルゲート株式会社 代表取締役 菊原政信