テキスト、アートに次いで音楽の世界にも生成AIが活用されてくる時代が迫ってきました。今回は、長い年月を経て人間がつくり出してきた音楽をAIはどこまで作りだすことができるか音楽の歴史振り返りながら検証してみます。

音楽:世界共通のコミュニケーション手段

音楽の起源は人類の歴史の初期にまでさかのぼります。具体的な始まりの時期や場所はわかっていませんが、考古学的な証拠からは、早い時期の人々が音楽を作り、演奏し、楽しんでいたことが示されています。

最も古い楽器の遺物は、約4万年前の旧石器時代のものとされています。これらの遺物は、骨や石を加工して作られたフルートや笛のようなものでした。これらの楽器は、音楽を作るために使用されたと考えられています。

さらに、古代文明の遺跡からも音楽の証拠が見つかっています。たとえば、紀元前3千年紀のメソポタミア文明では、音楽が宗教儀式や祭りの一部として行われていたことが示されています。また、古代エジプトや古代ギリシャでも音楽が重要な役割を果たしていました。

音楽の起源は、人間の本能的な音響的表現やコミュニケーションの一形態と関連していると考えられています。音楽は感情や意図を表現し、人々を結びつけ、文化や伝統を伝える手段として使用されてきました。

ルネッサンス期からクラッシック・近代音楽への軌跡

近代西洋音楽の起源は、ルネサンス期(14世紀から17世紀)にさかのぼります。この時期になると、音楽は宗教音楽から世俗音楽への転換が進み、音楽の理論と表現方法が大きく変化しました。

ルネサンス期には、芸術と知識の再興が起こりました。人文主義の思想が浸透し、古代ギリシャやローマの文化が再評価されました。音楽もこの流れに乗って、古代ギリシャの音楽理論や美学の再興が起こりました。

ルネサンス期における最も重要な音楽の発展は、ポリフォニーと呼ばれる多声音楽の形式です。これは、複数の独立した旋律が同時に進行し、対位法的な関係を持つ音楽です。ポリフォニーの代表的な形式として、モテットやフーガなどがあります。

この時期には、作曲家たちも重要な存在となりました。例えば、ジョスカン・デ・プレやギヨーム・デュファイなどの作曲家は、多声音楽の発展に貢献しました。また、イタリアの作曲家ジョヴァンニ・ダ・パレストリーナは、宗教音楽の分野で重要な業績を残しました。

ルネサンス期の音楽は、芸術的な表現の拡大と技術的な進歩を通じて、現代の西洋音楽の基礎を築きました。そして、この時期の音楽の発展は、バロック期(17世紀から18世紀)を経て、クラシック期、ロマン派、近代音楽へと続いていきました。

エレクトリック音楽全盛の時代

これまでは楽器自体が出す音色を主体とした演奏が主体でしたが、1960年代になりロバート・モーグが開発したモノフォニックシンセサイザーの登場により疑似的な楽器の音色や自然界の音を電子音として表現するシンセサイザーが開発されました。しかし当時は、一度に1つの音しか演奏できませんでしたが、1970年代になると複数の音を同時に演奏できるポリフォニックシンセサイザーが登場しました。これにより、和音や多重メロディの表現が可能になり、より豊かな音楽制作が可能となりました。

更に1980年代に入るとデジタル技術の進歩によってデジタルシンセサイザーが登場しました。デジタルシンセサイザーは、アナログシンセサイザーとは異なる方式で音を生成し、より多様な音色やエフェクトを提供しました。

その後1990年代以降はコンピュータの進化と音楽制作ソフトウェアの発展により、ソフトウェア上で動作するシンセサイザーソフトウェアシンセサイザー(1990年代以降): コンピュータの進化と音楽制作ソフトウェアの発展により、ソフトウェア上で動作するシンセサイザーの登場は、エレクトロニック音楽の世界に大きな変革をもたらしました。専用のハードウェアを必要とせず、パーソナルコンピュータ上で動作します。これにより、音楽制作におけるアクセスの容易さとコストの低減が実現されました。音楽制作者は、ソフトウェアシンセサイザーを手軽に入手し、利用することができるようになりました。これにより音楽制作者は新たな音楽的概念を探求し、独自のサウンドを創造することができるようになりました。

現在、ソフトウェアシンセサイザーは、エレクトロニック音楽制作の手段として広く受け入れられ、多くの音楽制作者やプロデューサーによって活用されています。その進化は、エレクトリック音楽の表現の幅を広げ、新たなサウンドの探求を促進しています。

デジタルによる音楽と生成AIの融合

このようにサウンドと音楽の根本となるメロディやハーモニー、リズムがコンピューターで制御可能になったことによりAIが学習できる下地ができました。現在、様々な取り組みがされているのでいくつかご紹介します。

AIを用いた音楽生成は、既存の楽曲の分析やパターンの学習に基づいて新しい楽曲を作り出すことが可能となりました。メロディやハーモニー、リズムなどの音楽要素を学習し、独自の作曲を行うことができます。例えば「Amper Music」などのプラットフォームでは、ユーザーがAIにパラメータを指定することで、自動的にオリジナルの音楽を生成することができます。

既存の楽曲に合わせて自動的に伴奏を生成することも可能です。例えば、音楽ジャムセッションアプリ「ChordAI」や「AIVA」などは、リアルタイムに楽器の伴奏を生成し、ユーザーがそれに合わせて演奏することができるよう支援しています。

身近なところでは、音楽の特徴やパターンを学習し、楽曲を分類したり、ユーザーに対して個別の音楽推薦を行ったりすることができます。SpotifyやApple Musicなどの音楽ストリーミングサービスでは、ユーザーの好みや再生履歴に基づいて、AIが音楽の選曲を行っています。

楽器演奏の支援や即興演奏の応答としても活用されています。例えば、演奏者が演奏するとAIがそれに応じて即座に反応し、対話的な音楽体験を提供するシステムが開発されています。

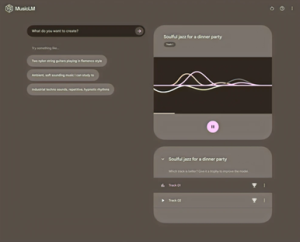

最近では、Googleが開発を進めている「MusicLM」など、入力された単語や文章に応じて音楽が生成される生成AIが注目されています。まだ、発展途上で曲作りとしては完成には至っていませんが、今後更にAIが学習を進めることでこの精度も高まって行く事でしょう。

フィルゲート株式会社 代表取締役 菊原政信